前の10件 | -

チキンラーメンの不思議 [その他]

(2018.11.12)

スーパーマーケットのインスタント・ラーメン売り場に行って驚いた。

販売開始(1958年)から60年経つチキンラーメン(日清食品)が未だに店頭に並んでいるとは・・・知らなかった。orz

https://ja.wikipedia.org/wiki/%E3%83%81%E3%82%AD%E3%83%B3%E3%83%A9%E3%83%BC%E3%83%A1%E3%83%B3

あらためて棚を眺めてみると、チキンラーメンだけではなく、チャルメラ(明星食品)やサッポロ一番(サンヨー食品)など、時代を超えたロングラーがズラッと並んでいる。

マルちゃん正麺(東洋水産)など新製品の開発を怠っているわけでは無さそうだが、慣れ親しまれた定番ラーメンに取って代わるだけの力は無い(↓)らしい。

https://news.mynavi.jp/article/20180515-2-osusume_navi/

気付いたのはインスタントラーメンの個包装(一個売り)が無くなったことで、袋入りラーメンは全て5個入りパックになっていた。

新製品の開発に取り組みつつ、50年前のインスタントラーメンを未だに提供し続けるインスタントラーメン業界って、とっても不思議だ!

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

スーパーマーケットのインスタント・ラーメン売り場に行って驚いた。

販売開始(1958年)から60年経つチキンラーメン(日清食品)が未だに店頭に並んでいるとは・・・知らなかった。orz

https://ja.wikipedia.org/wiki/%E3%83%81%E3%82%AD%E3%83%B3%E3%83%A9%E3%83%BC%E3%83%A1%E3%83%B3

あらためて棚を眺めてみると、チキンラーメンだけではなく、チャルメラ(明星食品)やサッポロ一番(サンヨー食品)など、時代を超えたロングラーがズラッと並んでいる。

マルちゃん正麺(東洋水産)など新製品の開発を怠っているわけでは無さそうだが、慣れ親しまれた定番ラーメンに取って代わるだけの力は無い(↓)らしい。

https://news.mynavi.jp/article/20180515-2-osusume_navi/

気付いたのはインスタントラーメンの個包装(一個売り)が無くなったことで、袋入りラーメンは全て5個入りパックになっていた。

新製品の開発に取り組みつつ、50年前のインスタントラーメンを未だに提供し続けるインスタントラーメン業界って、とっても不思議だ!

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

ヤフオク [その他]

(2018.11.08)

これ(↓)に入札するつもりで様子を見ていました。

https://page.auctions.yahoo.co.jp/auction/g305300511

¥1000から始まり前日の昼頃に¥5700の値が付きました。ここからどこまで行くか?

¥15000位ならと思っていたのですが・・・

あっさり¥20000越えして落札価格は¥33,833!

本気で取りに来ている方には敵いません。

今年の正月も例年と同じお椀で雑煮を食べることになりそうです。

お粗末。

ーーーーーーーーーーーーーーーーーーーーーーーーーーー

こんなの(↓)はどうでしょう?

これ(↓)に入札するつもりで様子を見ていました。

https://page.auctions.yahoo.co.jp/auction/g305300511

¥1000から始まり前日の昼頃に¥5700の値が付きました。ここからどこまで行くか?

¥15000位ならと思っていたのですが・・・

あっさり¥20000越えして落札価格は¥33,833!

本気で取りに来ている方には敵いません。

今年の正月も例年と同じお椀で雑煮を食べることになりそうです。

お粗末。

ーーーーーーーーーーーーーーーーーーーーーーーーーーー

こんなの(↓)はどうでしょう?

コテ先温度センサを購入した [電子工作]

(2018.11.06)

半田付け支援装置にコテ先温度計測機能を組み込もうとしています。試作用にコテ先温度センサを購入することにしました。

コテ先温度計用のセンサ(K型熱電対)は、白光と太洋電機産業から販売されています。値段的にはほぼ同じですが、白光は3端子10個入り、太洋電機産業は2端子3個入りです。

候補その1

https://www.yodobashi.com/product/100000001001987524/?gad1=&gad2=g&gad3=&gad4=56278881131&gad5=10663992019704986258&gad6=1o1&gclid=EAIaIQobChMIioL6mYm_3gIVyLWWCh1KSgDMEAQYASABEgKnQPD_BwE&xfr=pla

候補その2

https://www.yodobashi.com/product/100000001001987527/?gad1=&gad2=g&gad3=&gad4=56278881131&gad5=8837589895970450272&gad6=1o3&gclid=EAIaIQobChMIlt2-loe_3gIVSqaWCh0IHwtlEAYYAyABEgJCsPD_BwE&xfr=pla

機械的に強そうで配置も楽な太洋電機産業の方を購入することにしました。

送料込みの値段で比較すると、ヨドバシ.comが一番安かったので早速注文しました。

最近は試作段階からプリント基板化することが多くなっています。

基板上にセンサを直接取り付ける方式で設計を進めようと思います。

半田付け支援装置にコテ先温度計測機能を組み込もうとしています。試作用にコテ先温度センサを購入することにしました。

コテ先温度計用のセンサ(K型熱電対)は、白光と太洋電機産業から販売されています。値段的にはほぼ同じですが、白光は3端子10個入り、太洋電機産業は2端子3個入りです。

候補その1

https://www.yodobashi.com/product/100000001001987524/?gad1=&gad2=g&gad3=&gad4=56278881131&gad5=10663992019704986258&gad6=1o1&gclid=EAIaIQobChMIioL6mYm_3gIVyLWWCh1KSgDMEAQYASABEgKnQPD_BwE&xfr=pla

候補その2

https://www.yodobashi.com/product/100000001001987527/?gad1=&gad2=g&gad3=&gad4=56278881131&gad5=8837589895970450272&gad6=1o3&gclid=EAIaIQobChMIlt2-loe_3gIVSqaWCh0IHwtlEAYYAyABEgJCsPD_BwE&xfr=pla

機械的に強そうで配置も楽な太洋電機産業の方を購入することにしました。

送料込みの値段で比較すると、ヨドバシ.comが一番安かったので早速注文しました。

最近は試作段階からプリント基板化することが多くなっています。

基板上にセンサを直接取り付ける方式で設計を進めようと思います。

徴用工判決 [その他]

(2018.10.31)

『韓国大法院(最高裁)が元徴用工への損害賠償を新日鉄住金(旧新日本製鉄)に命じた判決』を巡って、日韓の関係に新たな火種が起きている。

韓国大法院が認めた元徴用工の損害賠償請求権をどう扱うか?が問題な訳で、韓国大法院の判決を覆すことなく、日韓合意に基づいて解決するとなると・・・

『賠償金相当額を韓国政府が新日鉄住金に支払い、それを原資に新日鉄住金が元徴用工に損害賠償を行えば良い』と思うのだが・・・

そんな簡単な話ではないのだろうか?

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

すこし、間が空いたので柄でもなく時事ネタを投稿してみました。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

管理人もお世話になっています。(↓)

『韓国大法院(最高裁)が元徴用工への損害賠償を新日鉄住金(旧新日本製鉄)に命じた判決』を巡って、日韓の関係に新たな火種が起きている。

韓国大法院が認めた元徴用工の損害賠償請求権をどう扱うか?が問題な訳で、韓国大法院の判決を覆すことなく、日韓合意に基づいて解決するとなると・・・

『賠償金相当額を韓国政府が新日鉄住金に支払い、それを原資に新日鉄住金が元徴用工に損害賠償を行えば良い』と思うのだが・・・

そんな簡単な話ではないのだろうか?

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

すこし、間が空いたので柄でもなく時事ネタを投稿してみました。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

管理人もお世話になっています。(↓)

Cousera Machine Learningの受講を終了した [Octave]

(2018.10.05)

Coursera Machine Learning(↓)の受講を終了しました。

https://www.coursera.org/learn/machine-learning/home/welcome

受講終了

受講終了

凡そ1ヶ月の受講でした。終わってみればあっと言う間ですが、試験に落ちまくったり、課題のプログラムが上手く動かなくて悩んだり・・・大変な思いもしました。それでも、中だるみすることもなく、最後まで一気に受講することが出来たのは、とても良いコースであるためだと思いました。

最初に受講を開始したときは手探り状態でしたが、段々様子が分かってきて(<==Week5の頃?)からビデオ講義の視聴も楽になりました。

私が掴んだコツは『新しい数式が出てきたときは一度ビデオを止め、良く眺めてから講義を再開する』というものです。丁寧に何度も繰り返すNg先生の説明を聞いて(見て?)いると何となく数式の意味が分かってきます。そして、ビデオ講義では曖昧だった理解も、プログラム課題に取り組む中ではっきりしたものになっていきます。

なので、プログラム課題の前に行う『テスト』では落ちまくります。orz

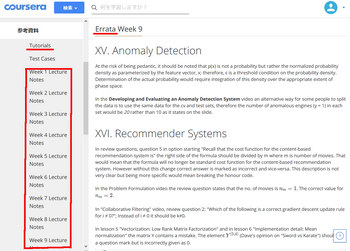

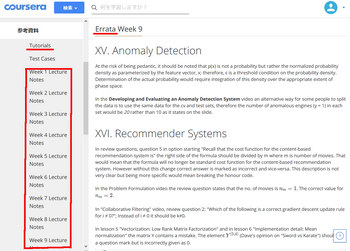

参考資料の中にある、『Tutorial』『Eratta』『Lecture Note』は必見です。

参考資料

参考資料

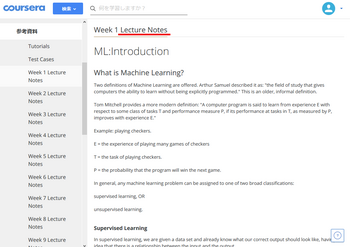

Lecture Note

Lecture Note

Lecture Noteは綺麗にまとめられていて講義資料として手元に残して置きたいのですが、ログインしないと表示されない仕組みになっていました。(<==受講期間は11月初旬まで)

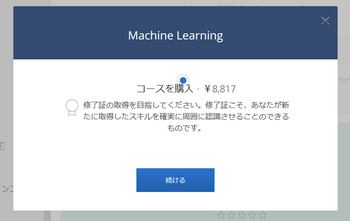

早速Courseraから「修了証」取得のお勧めメールが届きました。受講は無料ですが修了証を頂くには受講料(↓)を支払う必要があるようです。

受講料を支払うと修了証が貰える

受講料を支払うと修了証が貰える

このコースへの感謝の気持ちを込めて修了証代(?)を支払う方も多いようですが・・・

さて、どうしようか?

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

Coursera Machine Learning(↓)の受講を終了しました。

https://www.coursera.org/learn/machine-learning/home/welcome

受講終了

受講終了凡そ1ヶ月の受講でした。終わってみればあっと言う間ですが、試験に落ちまくったり、課題のプログラムが上手く動かなくて悩んだり・・・大変な思いもしました。それでも、中だるみすることもなく、最後まで一気に受講することが出来たのは、とても良いコースであるためだと思いました。

最初に受講を開始したときは手探り状態でしたが、段々様子が分かってきて(<==Week5の頃?)からビデオ講義の視聴も楽になりました。

私が掴んだコツは『新しい数式が出てきたときは一度ビデオを止め、良く眺めてから講義を再開する』というものです。丁寧に何度も繰り返すNg先生の説明を聞いて(見て?)いると何となく数式の意味が分かってきます。そして、ビデオ講義では曖昧だった理解も、プログラム課題に取り組む中ではっきりしたものになっていきます。

なので、プログラム課題の前に行う『テスト』では落ちまくります。orz

参考資料の中にある、『Tutorial』『Eratta』『Lecture Note』は必見です。

参考資料

参考資料 Lecture Note

Lecture NoteLecture Noteは綺麗にまとめられていて講義資料として手元に残して置きたいのですが、ログインしないと表示されない仕組みになっていました。(<==受講期間は11月初旬まで)

早速Courseraから「修了証」取得のお勧めメールが届きました。受講は無料ですが修了証を頂くには受講料(↓)を支払う必要があるようです。

受講料を支払うと修了証が貰える

受講料を支払うと修了証が貰えるこのコースへの感謝の気持ちを込めて修了証代(?)を支払う方も多いようですが・・・

さて、どうしようか?

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

Week9を終了した [Octave]

(2018.10.01)

Machine Learning(↓)のWeek9まで課題をクリアしました。

https://www.coursera.org/learn/machine-learning/home/welcome

== Part Name | Score | Feedback

== --------- | ----- | --------

== Estimate Gaussian Parameters | 15 / 15 | Nice work!

== Select Threshold | 15 / 15 | Nice work!

== Collaborative Filtering Cost | 20 / 20 | Nice work!

== Collaborative Filtering Gradient | 30 / 30 | Nice work!

== Regularized Cost | 10 / 10 | Nice work!

== Regularized Gradient | 10 / 10 | Nice work!

== --------------------------------

== | 100 / 100 |

パチパチパチ~

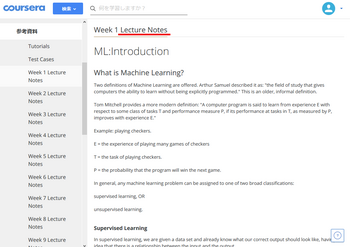

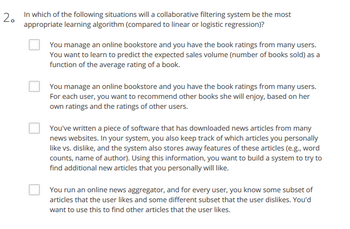

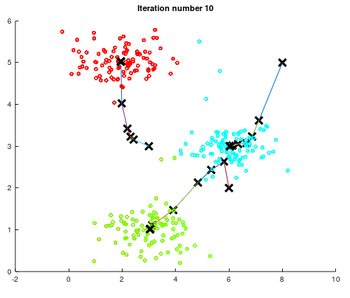

第9週は、異常検知(anomaly detection)と協調フィルタリング(Collaborative Filtering)でした。考え方としては判り易いと感じていたのですが・・・

また、テスト(Recommender System)に落ちてしまいました。orz

一番苦労した問題がこれ(↓)です。

問1から躓いた

問1から躓いた

次がこれ(↓)です。

問2にも苦労した

問2にも苦労した

最初の2問がなかなかクリアできず(<==この時点で不合格)、何度も受け直す羽目になりました。厄介なのは設問が微妙に変化するところです。また、講義では説明のなかった(<==多分)内容が設問に出てくるので、講座をしっかり理解できていないと、管理人のように何度もテストを受け直すことになります。

で、ようやく・・・

なんとか合格できた

なんとか合格できた

厳しい~

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

たまにはのんびり過ごしたいなぁ~

Machine Learning(↓)のWeek9まで課題をクリアしました。

https://www.coursera.org/learn/machine-learning/home/welcome

== Part Name | Score | Feedback

== --------- | ----- | --------

== Estimate Gaussian Parameters | 15 / 15 | Nice work!

== Select Threshold | 15 / 15 | Nice work!

== Collaborative Filtering Cost | 20 / 20 | Nice work!

== Collaborative Filtering Gradient | 30 / 30 | Nice work!

== Regularized Cost | 10 / 10 | Nice work!

== Regularized Gradient | 10 / 10 | Nice work!

== --------------------------------

== | 100 / 100 |

パチパチパチ~

第9週は、異常検知(anomaly detection)と協調フィルタリング(Collaborative Filtering)でした。考え方としては判り易いと感じていたのですが・・・

また、テスト(Recommender System)に落ちてしまいました。orz

一番苦労した問題がこれ(↓)です。

問1から躓いた

問1から躓いた次がこれ(↓)です。

問2にも苦労した

問2にも苦労した最初の2問がなかなかクリアできず(<==この時点で不合格)、何度も受け直す羽目になりました。厄介なのは設問が微妙に変化するところです。また、講義では説明のなかった(<==多分)内容が設問に出てくるので、講座をしっかり理解できていないと、管理人のように何度もテストを受け直すことになります。

で、ようやく・・・

なんとか合格できた

なんとか合格できた厳しい~

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

たまにはのんびり過ごしたいなぁ~

Week8を終了した [Octave]

(2018.09.28)

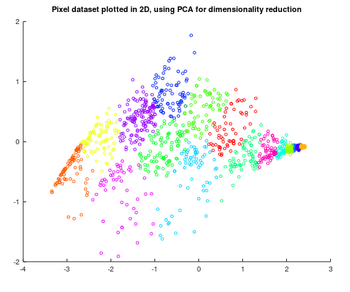

Machine Learning(↓)のWeek8まで課題をクリアしました。

https://www.coursera.org/learn/machine-learning/home/welcome

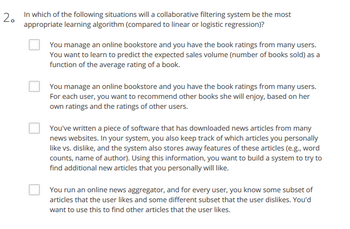

第8週は教師無し学習によるクラスタリング(K-means Clustering )と主成分分析(Principal Component Analysis)でした。昔、手計算でとても苦労して値を求めた(<==計算をミスして正解が出せなかった)記憶が蘇りました。

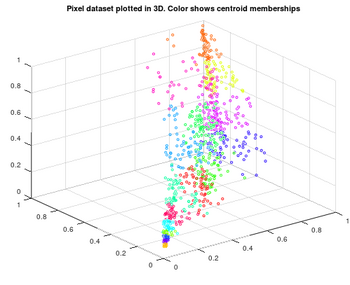

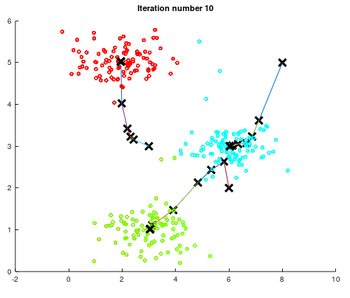

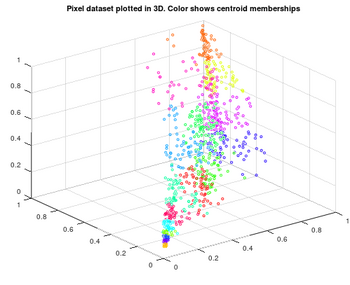

教師無し学習によるクラスタリングの実行結果です。二次元平面に散らばった点(便宜上色分けされている)をクラスター3でK-meansクラスタリングを反復して、収束する様子を描画した(↓)ものです。

K-means Clustering

K-means Clustering

<K-meansクラスタリング>

(1)サンプルデータを最も近い収束点(仮)に振り分ける。

(2)振り分けられたデータの平均値を次の収束点(仮)とする。

収束点に振り分けられるデータが変化しなくなるまで、この手順を反復して収束点を求めます。

最初の収束点(仮)をランダムに選んで、クラスタリングを複数回実施して最もバラツキの小さな収束点の組を選択します。

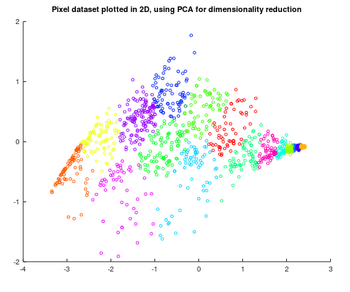

3次元ベクトルを2次元ベクトルに変換する例です。

3次元ベクトル(元)

3次元ベクトル(元)

主成分分析を用いて、2次元ベクトルに変換した。

2次元ベクトル(2次元近似)

2次元ベクトル(2次元近似)

<3次元データの2次元近似>

(1)正規化した元データ(3次元)の共分散行列を求める Sig=X'*X/m

(2)共分散行列の主成分分析(特異値分解?)を行う [U S V]= svd(Sig)

(3)2次元近似データを求める Z = X*U(:,1:K);

Octaveだとたったの3行で表現できてしまいます。

Octaveすげ~

<結果>

== Part Name | Score | Feedback

== --------- | ----- | --------

== Find Closest Centroids (k-Means) | 30 / 30 | Nice work!

== Compute Centroid Means (k-Means) | 30 / 30 | Nice work!

== PCA | 20 / 20 | Nice work!

== Project Data (PCA) | 10 / 10 | Nice work!

== Recover Data (PCA) | 10 / 10 | Nice work!

== --------------------------------

== | 100 / 100 |

==

パチパチパチ~

思いの外、順調に課題をクリアしています。

10月第一週の受講終了を目指します。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

息抜きも必要です。(↓)

管理人もお世話になっています。

Machine Learning(↓)のWeek8まで課題をクリアしました。

https://www.coursera.org/learn/machine-learning/home/welcome

第8週は教師無し学習によるクラスタリング(K-means Clustering )と主成分分析(Principal Component Analysis)でした。昔、手計算でとても苦労して値を求めた(<==計算をミスして正解が出せなかった)記憶が蘇りました。

教師無し学習によるクラスタリングの実行結果です。二次元平面に散らばった点(便宜上色分けされている)をクラスター3でK-meansクラスタリングを反復して、収束する様子を描画した(↓)ものです。

K-means Clustering

K-means Clustering<K-meansクラスタリング>

(1)サンプルデータを最も近い収束点(仮)に振り分ける。

(2)振り分けられたデータの平均値を次の収束点(仮)とする。

収束点に振り分けられるデータが変化しなくなるまで、この手順を反復して収束点を求めます。

最初の収束点(仮)をランダムに選んで、クラスタリングを複数回実施して最もバラツキの小さな収束点の組を選択します。

3次元ベクトルを2次元ベクトルに変換する例です。

3次元ベクトル(元)

3次元ベクトル(元)主成分分析を用いて、2次元ベクトルに変換した。

2次元ベクトル(2次元近似)

2次元ベクトル(2次元近似)<3次元データの2次元近似>

(1)正規化した元データ(3次元)の共分散行列を求める Sig=X'*X/m

(2)共分散行列の主成分分析(特異値分解?)を行う [U S V]= svd(Sig)

(3)2次元近似データを求める Z = X*U(:,1:K);

Octaveだとたったの3行で表現できてしまいます。

Octaveすげ~

<結果>

== Part Name | Score | Feedback

== --------- | ----- | --------

== Find Closest Centroids (k-Means) | 30 / 30 | Nice work!

== Compute Centroid Means (k-Means) | 30 / 30 | Nice work!

== PCA | 20 / 20 | Nice work!

== Project Data (PCA) | 10 / 10 | Nice work!

== Recover Data (PCA) | 10 / 10 | Nice work!

== --------------------------------

== | 100 / 100 |

==

パチパチパチ~

思いの外、順調に課題をクリアしています。

10月第一週の受講終了を目指します。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

息抜きも必要です。(↓)

管理人もお世話になっています。

Week7を終了した [Octave]

(2018.09.26)

Machine Learning(↓)のWeek7まで課題をクリアしました。

https://www.coursera.org/learn/machine-learning/home/welcome

第7週はサポートベクターマシン(SVM)を使った識別でした。

<結果>

==

== Part Name | Score | Feedback

== --------- | ----- | --------

== Gaussian Kernel | 25 / 25 | Nice work!

== Parameters (C, sigma) for Dataset 3 | 25 / 25 | Nice work!

== Email Preprocessing | 25 / 25 | Nice work!

== Email Feature Extraction | 25 / 25 | Nice work!

== --------------------------------

== | 100 / 100 |

パチパチパチ~

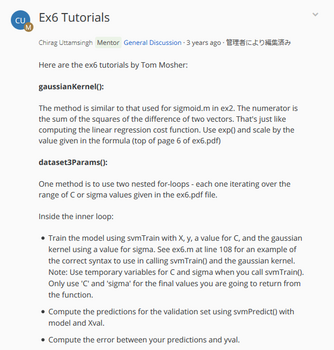

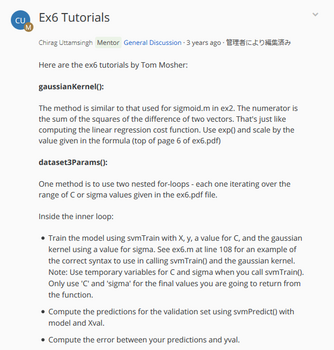

今回初めて参考資料のTutorialを利用して課題に取り組みました。

Ex6 Tutorialsが第7週の分

Ex6 Tutorialsが第7週の分

かみ砕いて説明してくれる訳ではありませんが、関数等の利用の仕方が示されるので、課題に取り組む方針が何となく見えてきます。

SVMのモデル作成と評価の手順は関数化されています(svmTrain関数とsvmPredict関数を利用する)。ですので、課題もSVMをどう使うか?という比較的優しい内容でした。

SVMのモデル構築と評価はこんな感じ(↓)です。

model= svmTrain(X, y, T_C, @(x1, x2) gaussianKernel(x1, x2, sig));

pred = svmPredict( model, Xval);

error = sum((pred - yval).^2);

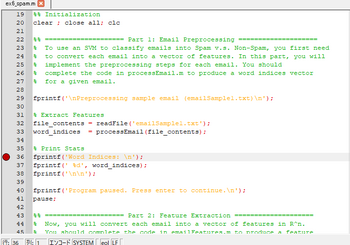

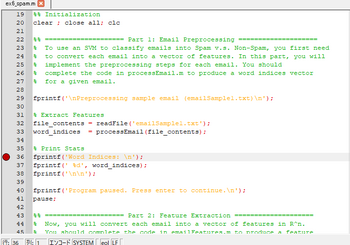

今回の一番大きな収穫は『デバッグ・モード』が使えるようになったことです。

Tutorialで「ブレーク・ポイントを設定して・・・」という説明を見て初めて、Octaveでプログラムにブレーク・ポイントを設定出来ることを知りました。(<==もっと早く知りたかった)

使い方はこんな感じです。

>> dbstop('ex6_spam',36); <==36行目にブレーク・ポイントを設定する

>> dbstatus

breakpoint in ex6_spam at line 36

>>ex6_spam

(プログラムが走って・・・)

=========================

stopped in C:\Users\akira\Desktop\Machine-Learning\machine-learning-ex6\ex6\ex6_spam.m at line 36

36: fprintf('Word Indices: \n'); <==36行目の実行前にブレークが掛かる

debug> <==デバッグモードのプロンプト

debug> who

Variables in the current scope:

file_contents word_indices <==関数内のローカル変数が見える

debug> dbstep <==ステップ実行する

Word Indices: <== 36行目の実行結果

stopped in C:\Users\akira\Desktop\Machine-Learning\machine-learning-ex6\ex6\ex6_spam.m at line 37

37: fprintf(' %d', word_indices); <==37行目の実行前に再びブレークが掛かる

debug> dbstep <==ステップ実行する

86 916 794 1077 883 370 1699 790 1822 1831 883 431 1171 794 1002 1893 1364 592 1676 238 162 89 688 945 1663 1120 106

2 1699 375 1162 479 1893 1510 799 1182 1237 810 1895 1440 1547 181 1699 1758 1896 688 1676 992 961 1477 71 530 1699 5 <== 37行目の実行結果

31stopped in C:\Users\akira\Desktop\Machine-Learning\machine-learning-ex6\ex6\ex6_spam.m at line 38

38: fprintf('\n\n');

debug>dbquit <==デバッグ・モードを抜ける

>>

ブレーク・ポイントを設定したプログラムをエディタでみるとこんな感じ(↓)でした。

ブレークを設定すると行番号の左に赤丸が付く

ブレークを設定すると行番号の左に赤丸が付く

行番号の左(赤丸の位置)をマウスでクリックするだけでブレーク・ポイントを設定/解除出来ることが判りました。(<==これは使える)

この技を知って、デバッグがかなり楽になったのではないか?と思います。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

管理人もお世話になっています。

Machine Learning(↓)のWeek7まで課題をクリアしました。

https://www.coursera.org/learn/machine-learning/home/welcome

第7週はサポートベクターマシン(SVM)を使った識別でした。

<結果>

==

== Part Name | Score | Feedback

== --------- | ----- | --------

== Gaussian Kernel | 25 / 25 | Nice work!

== Parameters (C, sigma) for Dataset 3 | 25 / 25 | Nice work!

== Email Preprocessing | 25 / 25 | Nice work!

== Email Feature Extraction | 25 / 25 | Nice work!

== --------------------------------

== | 100 / 100 |

パチパチパチ~

今回初めて参考資料のTutorialを利用して課題に取り組みました。

Ex6 Tutorialsが第7週の分

Ex6 Tutorialsが第7週の分かみ砕いて説明してくれる訳ではありませんが、関数等の利用の仕方が示されるので、課題に取り組む方針が何となく見えてきます。

SVMのモデル作成と評価の手順は関数化されています(svmTrain関数とsvmPredict関数を利用する)。ですので、課題もSVMをどう使うか?という比較的優しい内容でした。

SVMのモデル構築と評価はこんな感じ(↓)です。

model= svmTrain(X, y, T_C, @(x1, x2) gaussianKernel(x1, x2, sig));

pred = svmPredict( model, Xval);

error = sum((pred - yval).^2);

今回の一番大きな収穫は『デバッグ・モード』が使えるようになったことです。

Tutorialで「ブレーク・ポイントを設定して・・・」という説明を見て初めて、Octaveでプログラムにブレーク・ポイントを設定出来ることを知りました。(<==もっと早く知りたかった)

使い方はこんな感じです。

>> dbstop('ex6_spam',36); <==36行目にブレーク・ポイントを設定する

>> dbstatus

breakpoint in ex6_spam at line 36

>>ex6_spam

(プログラムが走って・・・)

=========================

stopped in C:\Users\akira\Desktop\Machine-Learning\machine-learning-ex6\ex6\ex6_spam.m at line 36

36: fprintf('Word Indices: \n'); <==36行目の実行前にブレークが掛かる

debug> <==デバッグモードのプロンプト

debug> who

Variables in the current scope:

file_contents word_indices <==関数内のローカル変数が見える

debug> dbstep <==ステップ実行する

Word Indices: <== 36行目の実行結果

stopped in C:\Users\akira\Desktop\Machine-Learning\machine-learning-ex6\ex6\ex6_spam.m at line 37

37: fprintf(' %d', word_indices); <==37行目の実行前に再びブレークが掛かる

debug> dbstep <==ステップ実行する

86 916 794 1077 883 370 1699 790 1822 1831 883 431 1171 794 1002 1893 1364 592 1676 238 162 89 688 945 1663 1120 106

2 1699 375 1162 479 1893 1510 799 1182 1237 810 1895 1440 1547 181 1699 1758 1896 688 1676 992 961 1477 71 530 1699 5 <== 37行目の実行結果

31stopped in C:\Users\akira\Desktop\Machine-Learning\machine-learning-ex6\ex6\ex6_spam.m at line 38

38: fprintf('\n\n');

debug>dbquit <==デバッグ・モードを抜ける

>>

ブレーク・ポイントを設定したプログラムをエディタでみるとこんな感じ(↓)でした。

ブレークを設定すると行番号の左に赤丸が付く

ブレークを設定すると行番号の左に赤丸が付く行番号の左(赤丸の位置)をマウスでクリックするだけでブレーク・ポイントを設定/解除出来ることが判りました。(<==これは使える)

この技を知って、デバッグがかなり楽になったのではないか?と思います。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

管理人もお世話になっています。

Week6の中間テストに落ちた [Octave]

(2018.09.25)

Machine Learning(↓)を受講しています。

https://www.coursera.org/learn/machine-learning/home/welcome

Week6の中間テストに落ちてしまいました.orz

テストの回答が手元に残らないので、何故不正解となったのか?回答のどこに誤りがあったのか?検討できないのが困りものです。

3回までのリトライが許されていて、3回とも80点以下だと再度試験を受ける前に8時間の補講時間が課せられます。3回目を受ける前に講義資料には目を通したのに落ちるとは・・・

一晩寝てから講義資料に今一度目を通し、再受験してようやく中間テストに合格しました。

ふと気がつくと、COURSERAからメールが届いていました。表題は『Don't give up!』

細やかな気遣いに感謝! <(_ _)>

大丈夫です。諦める気は有りません。ここまで来たんですから・・・

何とか後半のテストとプログラミング課題も提出し、Week6は4日掛けて受講を終えることが出来ました。

やれやれ

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

これまでディスカッションフォーラム(↓)は見ていなかったのですが、講義の補講として参照するのも良いかもしれません。

https://www.coursera.org/learn/machine-learning/discussions

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

やっぱりPython・・・と言う方には(↓)

管理人もお世話になってます。(↓)

Machine Learning(↓)を受講しています。

https://www.coursera.org/learn/machine-learning/home/welcome

Week6の中間テストに落ちてしまいました.orz

テストの回答が手元に残らないので、何故不正解となったのか?回答のどこに誤りがあったのか?検討できないのが困りものです。

3回までのリトライが許されていて、3回とも80点以下だと再度試験を受ける前に8時間の補講時間が課せられます。3回目を受ける前に講義資料には目を通したのに落ちるとは・・・

一晩寝てから講義資料に今一度目を通し、再受験してようやく中間テストに合格しました。

ふと気がつくと、COURSERAからメールが届いていました。表題は『Don't give up!』

細やかな気遣いに感謝! <(_ _)>

大丈夫です。諦める気は有りません。ここまで来たんですから・・・

何とか後半のテストとプログラミング課題も提出し、Week6は4日掛けて受講を終えることが出来ました。

やれやれ

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

これまでディスカッションフォーラム(↓)は見ていなかったのですが、講義の補講として参照するのも良いかもしれません。

https://www.coursera.org/learn/machine-learning/discussions

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

やっぱりPython・・・と言う方には(↓)

管理人もお世話になってます。(↓)

Week4のプログラミング課題を見直した [Octave]

(2019.09.22)

Machine Learning(↓)のWeek6を受講しています。Andrew Ng先生のビデオ講義にも慣れました。

https://www.coursera.org/learn/machine-learning/home/welcome

少し難し目のコースを順調に受講できているのは、プログラムが上手く動かない時に他の方のコードを参照することを厭わないためだと思っています。自嘲気味に『カンニング』と呼んでいますが・・・

学校なら『カンニング』はタブーかもしれません。けれどもエンジニアの現場では不具合を確実かつ速やかに解決するための手段は選びません。確かな情報を求めて手あたり次第に調べるのは当然のことです。なので、自分で書いたコードが上手く動かないとき、他の方のコードを参照して不具合箇所を探すことにためらいはありません。いずれ、正解の無い問題に取り組むことになるのですから、正解がそこにある間はそれを利用した方が良いと思います。これはCoursera-Honor-Codeを知った上で表明する管理人の考えです。もしMachine Learningコースを受講中で、Coursera-Honor-Codeを知らずにこのサイトを訪れた方がいらっしゃいましたら、是非Coursera-Honor-Code(↓)をご一読下さい。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

<Coursera-Honor-Code>

https://learner.coursera.help/hc/en-us/articles/209818863-Coursera-Honor-Code

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

先日(↓)、Week4のプログラミング課題を達成率80%で合格したとお伝えしました。

https://broadbeans.blog.so-net.ne.jp/2018-09-20

気になっていたので、少し調べて(<==他の方のコードと比べて)みることにしました。

lrCostFunction.mは・・・問題なさそうです。oneVsAll.mも問題無さそうなんだけど・・・ん!

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

英語で受講するのは・・・やっぱりPythonが・・・という方にこれなどは如何でしょう

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

『 for c = 1:10』を『 for c = 1:num_labels』に替えてようやく正解になりました。

やれやれ

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

<Pythonを使って機械学習>

Machine Learning(↓)のWeek6を受講しています。Andrew Ng先生のビデオ講義にも慣れました。

https://www.coursera.org/learn/machine-learning/home/welcome

少し難し目のコースを順調に受講できているのは、プログラムが上手く動かない時に他の方のコードを参照することを厭わないためだと思っています。自嘲気味に『カンニング』と呼んでいますが・・・

学校なら『カンニング』はタブーかもしれません。けれどもエンジニアの現場では不具合を確実かつ速やかに解決するための手段は選びません。確かな情報を求めて手あたり次第に調べるのは当然のことです。なので、自分で書いたコードが上手く動かないとき、他の方のコードを参照して不具合箇所を探すことにためらいはありません。いずれ、正解の無い問題に取り組むことになるのですから、正解がそこにある間はそれを利用した方が良いと思います。これはCoursera-Honor-Codeを知った上で表明する管理人の考えです。もしMachine Learningコースを受講中で、Coursera-Honor-Codeを知らずにこのサイトを訪れた方がいらっしゃいましたら、是非Coursera-Honor-Code(↓)をご一読下さい。

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

<Coursera-Honor-Code>

https://learner.coursera.help/hc/en-us/articles/209818863-Coursera-Honor-Code

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

先日(↓)、Week4のプログラミング課題を達成率80%で合格したとお伝えしました。

https://broadbeans.blog.so-net.ne.jp/2018-09-20

気になっていたので、少し調べて(<==他の方のコードと比べて)みることにしました。

lrCostFunction.mは・・・問題なさそうです。oneVsAll.mも問題無さそうなんだけど・・・ん!

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

英語で受講するのは・・・やっぱりPythonが・・・という方にこれなどは如何でしょう

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

<誤>

for c = 1:10

[ theta ] = fmincg (@(t)(lrCostFunction(t, X, (y == c), lambda)), initial_theta, options);

all_theta(c,:) = theta(:);

endfor

submitした結果

Iteration 28 | Cost: 3.391340e-01

Iteration 25 | Cost: 6.631438e-02

Iteration 31 | Cost: 1.002636e-01

Iteration 20 | Cost: 3.598119e-01

Iteration 50 | Cost: 2.353348e-07

Iteration 50 | Cost: 2.353348e-07

Iteration 50 | Cost: 2.353348e-07

Iteration 50 | Cost: 2.353348e-07

Iteration 50 | Cost: 2.353348e-07

Iteration 50 | Cost: 2.353348e-07

==

== Part Name | Score | Feedback

== --------- | ----- | --------

== Regularized Logistic Regression | 30 / 30 | Nice work!

== One-vs-All Classifier Training | 0 / 20 | <==不正解

== One-vs-All Classifier Prediction | 20 / 20 | Nice work!

== Neural Network Prediction Function | 30 / 30 | Nice work!

== --------------------------------

== | 80 / 100 |

==

<正>

for c = 1:num_labels

[ theta ] = fmincg (@(t)(lrCostFunction(t, X, (y == c), lambda)), initial_theta, options);

all_theta(c,:) = theta(:);

endfor

submitした結果

Iteration 28 | Cost: 3.391340e-01

Iteration 25 | Cost: 6.631438e-02

Iteration 31 | Cost: 1.002636e-01

Iteration 20 | Cost: 3.598119e-01

==

== Part Name | Score | Feedback

== --------- | ----- | --------

== Regularized Logistic Regression | 30 / 30 | Nice work!

== One-vs-All Classifier Training | 20 / 20 | Nice work!

== One-vs-All Classifier Prediction | 20 / 20 | Nice work!

== Neural Network Prediction Function | 30 / 30 | Nice work!

== --------------------------------

== | 100 / 100 |

『 for c = 1:10』を『 for c = 1:num_labels』に替えてようやく正解になりました。

やれやれ

ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー

<Pythonを使って機械学習>

前の10件 | -